Что такое Data Science

интерпретацией больших объемов данных с использованием различных методов, таких как машинное обучение, статистика, системный анализ и высшая математика. Основная цель Data Science заключается в том, чтобы извлечь ценную информацию и знания из огромных и сложных наборов данных.

Когда речь идет о зеттабайтах данных (экстремально большие объемы данных), основной вызов состоит в обработке, хранении, анализе и интерпретации этих данных. Data Scientists разрабатывают и применяют различные алгоритмы, модели и инструменты для обработки и анализа данных с целью получить полезные и практические выводы.

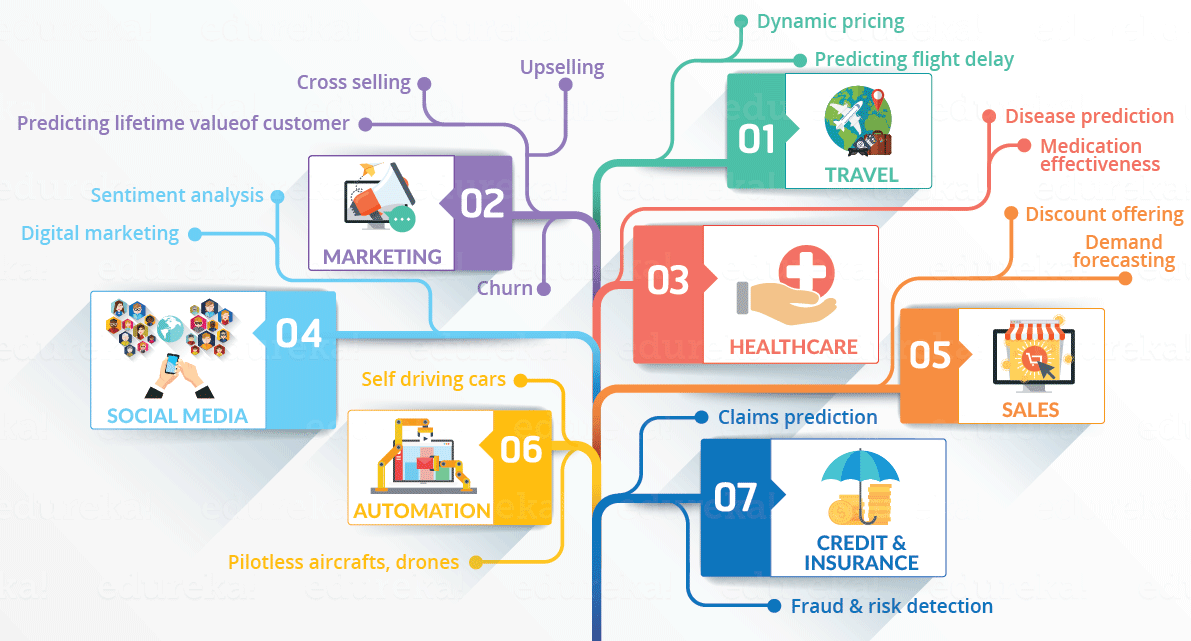

Использование науки о данных может быть весьма разнообразным. Она может помочь в решении ежедневных проблем в различных отраслях экономики, таких как медицина, финансы, маркетинг, транспорт, информационные технологии и многие другие. Data Science позволяет выявлять закономерности, тренды и скрытые взаимосвязи в данных, что может привести к более эффективным решениям, оптимизации процессов и улучшению бизнес-результатов.

Простыми словами, Data Science — это наука о данных, позволяющая выводить закономерности в любых отраслях науки, бизнеса, медицины и других сферах жизни.

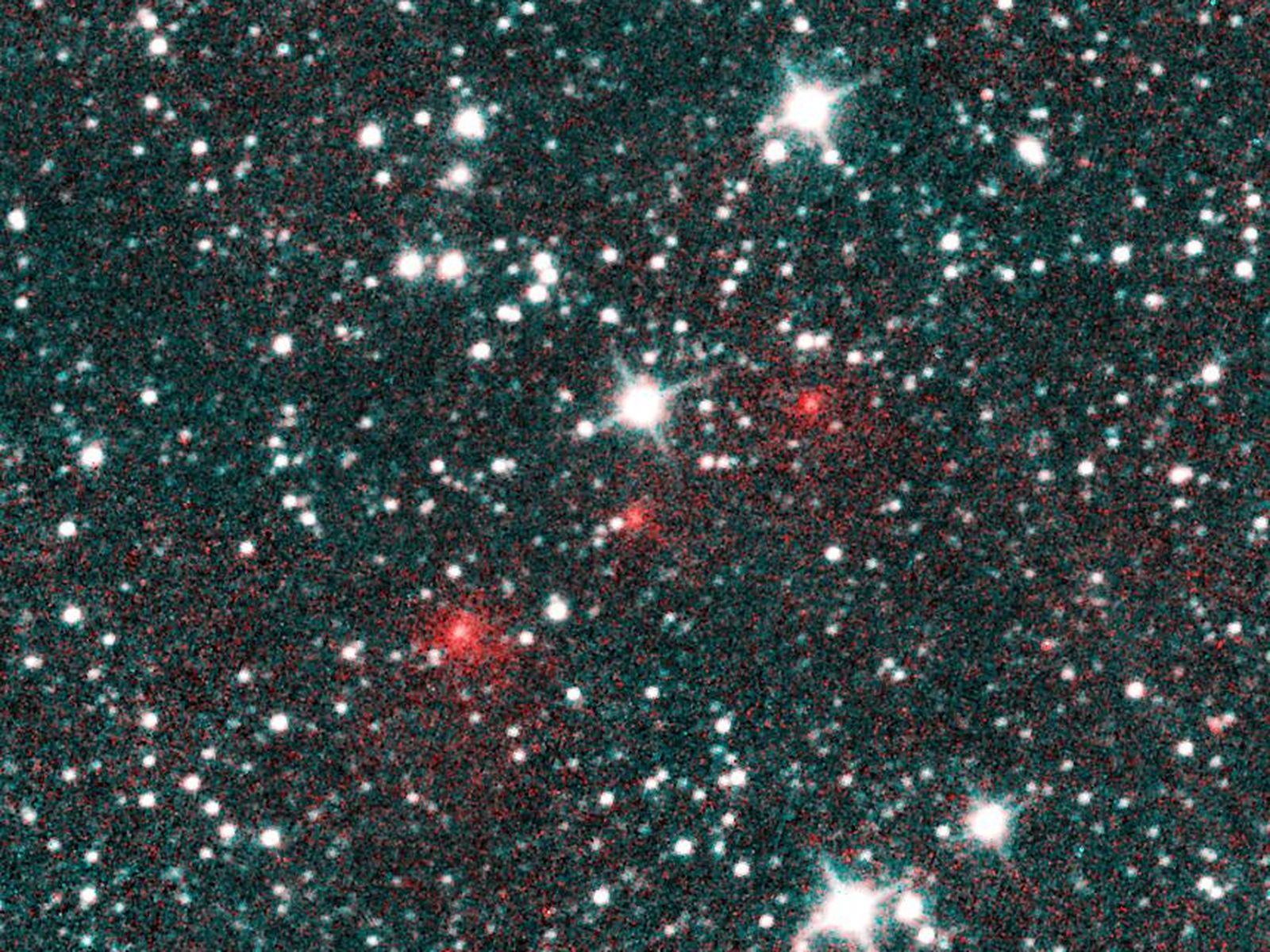

Комету NEOWISE (серия красных точек) обнаружили в результате анализа данных астрономических наблюдений

Комету NEOWISE (серия красных точек) обнаружили в результате анализа данных астрономических наблюдений

Специалисты по данным чаще всего полагаются на искусственный интеллект и машинное обучение.

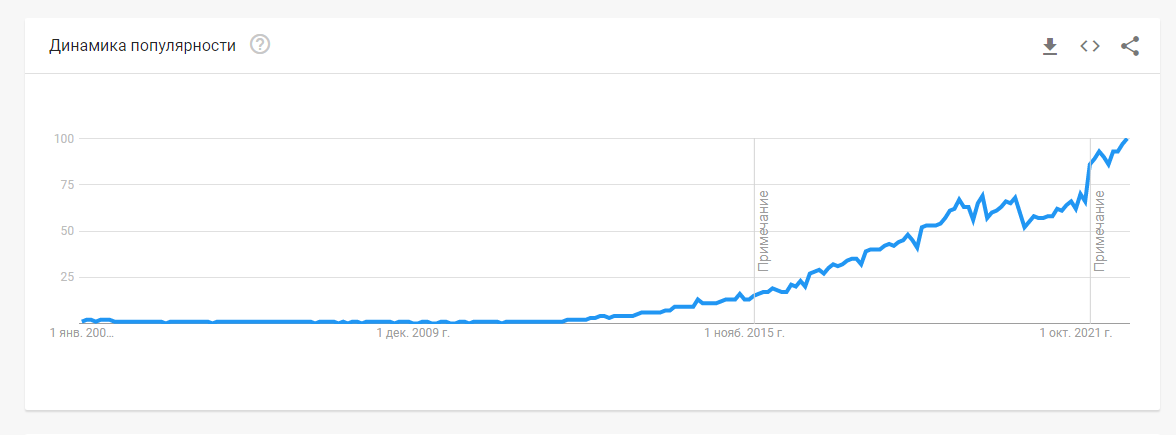

Интерес к науке о данных начал расти в конце 2012 года

Интерес к науке о данных начал расти в конце 2012 года

Примеры отраслей дата-саенс:

- Статистика. Изучение статистики в любых аспектах и проблемах.

- Анализ данных. Обработка raw-данных с целью придания им необходимого вида, например, для подтверждения или опровержения гипотез.

- ИИ (искусственный интеллект). Обучение алгоритмов на реальных данных.

Зачем и какому бизнесу нужна Data Science

Когда бизнесу нужно задействовать науку о данных? Типичный кандидат на найм дата-сайентиста — крупный бизнес, у которого:

- Накопилось огромное количество данных и есть желание их использовать. Беспорядочные массы терабайт «сырых данных» бизнесу ни к чему. Ему нужны данные, которые подтвердят или опровергнут определенную теорию, помогут стимулировать инновации или увеличат эффективность текущих продуктов.

- Очень большой бюджет на эксперименты. Мало получить и подготовить данные, необходимо также их внедрить и перестроить работу бизнеса на основе новых теорий. Обработанные данные полезны только тогда, когда бизнес может позволить себе меняться.

- Компания относится к отраслям: ecommerce, финансы, спорт, здравоохранение, государственное управление, логистическая ниша, недвижимость, реклама, промышленность. Для этих сфер экономики уже существуют готовые модели машинного обучения.

Основные отрасли экономики, где наука о данных показывает себя с наивысшей эффективностью

Основные отрасли экономики, где наука о данных показывает себя с наивысшей эффективностью

Кто такой специалист Data Science

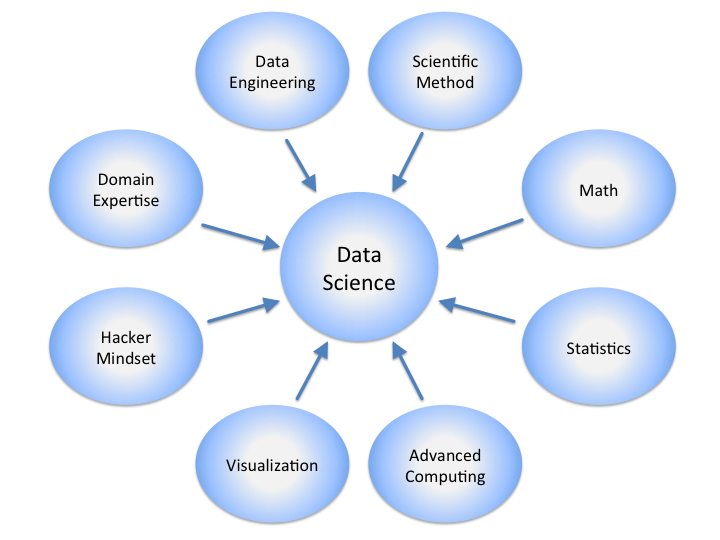

Наука о данных включает в себя несколько дисциплин для максимально целостного, точного и тщательного изучения любых необработанных типов данных.

Основные дисциплины Data Science

Специалист Data Science (специалист по науке о данных) — это высококвалифицированный профессионал, который обладает знаниями, навыками и опытом в области анализа данных и применения различных методов и инструментов для извлечения ценной информации и знаний из больших объемов данных.

Он обладает глубокими знаниями в области статистики, машинного обучения, алгоритмов и моделей анализа данных, а также программирования и баз данных. Специалист Data Science должен быть в состоянии собирать, очищать, обрабатывать и анализировать данные, применять различные статистические методы и алгоритмы для выявления закономерностей и трендов, разрабатывать предиктивные и оптимизационные модели, а также интерпретировать результаты и визуализировать их для понимания и принятия решений.

Специалист Data Science должен обладать аналитическим мышлением, креативностью и умением находить новые подходы к анализу данных. Он должен быть хорошо знаком с различными инструментами и технологиями, используемыми в области Data Science,имеет широкий опыт использования языков программирования, такими как языки программирования (например, Python, R), инструменты анализа данных (например, TensorFlow, PyTorch), системы управления базами данных и облачные вычисления.

Специалисты Data Science широко применяются в различных отраслях, включая бизнес и финансы, медицину, маркетинг, транспорт, образование и другие. Их роль заключается в том, чтобы помочь компаниям и организациям принимать информированные решения, оптимизировать процессы, предсказывать тренды и повышать эффективность своей деятельности на основе анализа данных.

Реальные требования к соискателю на позицию дата-сайентист с зарплатой 150 000 – 200 000 рублей

Реальные требования к соискателю на позицию дата-сайентист с зарплатой 150 000 – 200 000 рублей

Не стоит путать дата-сайентиста с бизнес-сайентистом или бизнес-аналитиком. Эти специалисты работают только с коммерческими показателями бизнеса. Например, оценивают успешность продвижения в каждом конкретном канале, анализируют количество заявок за определенный период или проверяют другие коммерческие метрики бизнеса.

Также не стоит путать дата-сайентиста с дата-инженером. Дата-инженер только занимается физической добычей, сбором данных, настраивает выгрузку и объединяет данные из нескольких источников. Дата-сайентист — проверяет гипотезы, тестирует их в необходимых системах, создает алгоритмы.

Чем занимается специалист по Data Science

Прежде чем отвечать на этот вопрос, давайте рассмотрим науку о данных с точки зрения этапов ее жизненного цикла:

- Захват данных: сбор, ввод, прием и извлечение.

- Обслуживание и поддержка: хранение данных, их очистка и подготовка, а также обработка и создание классификации.

- Процесс: интеллектуальный анализ данных, кластеризация и классификация, моделирование данных и суммирование.

- Анализ данных: отчеты о данных, их визуализация, бизнес-аналитика и принятие решений.

- Коммуникация: исследовательский и подтверждающий анализ, прогнозный анализ, регрессия, анализ текста и качественный анализ.

Три типа статистических и аналитических методов — классификация, регрессия и кластеризация

Три типа статистических и аналитических методов — классификация, регрессия и кластеризация

Если подытожить, дата-сайентист ищет закономерности в больших данных и формирует полезные модели, которые можно использовать практически — например, прогнозную. Алгоритмы всегда формируются на основе реальных пользовательских данных.

Модель DS может быть использована для прогнозов или предсказания определенного результата. Находя связи в данных и устанавливая закономерности, дата-сайентист может тестировать и внедрять сформированные им алгоритмы и модели машинного обучения.

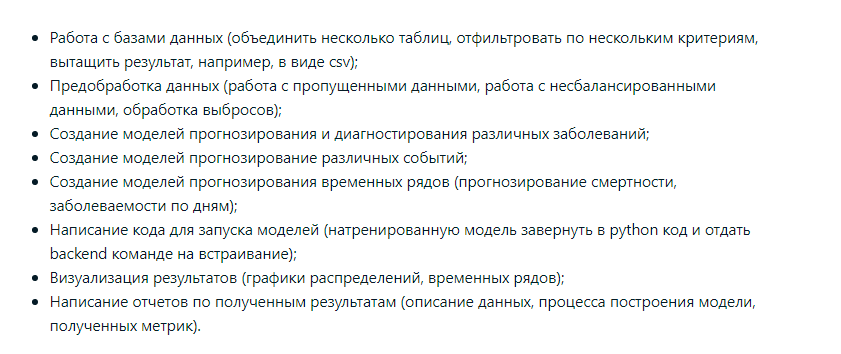

Должностные обязанности специалиста по Data Science

Круг обязанностей специалиста по данным может отличаться от компании к компании. Например, в одном банке специалист может заниматься исключительно вопросами скоринга, в другом — только вопросами по конкретному банковскому продукту. Но чаще всего список таких обязанностей у специалиста примерно одинаковый.

Пример обязанностей для программиста данных на одном из сайте с вакансиями

Пример обязанностей для программиста данных на одном из сайте с вакансиями

Вот основные обязанности специалиста:

- Тщательный анализ ТЗ.

- Создание модели. Тестирование основной функциональности. Доработка модели при необходимости.

- Сопровождение созданной модели.

- Поэтапное внедрение созданной модели. Такое внедрение может касаться не только непосредственного продукта бизнеса, но и бизнес-процессов в широком смысле.

- Подготовка полученных от инженера данных.

- Разметка подготовленных данных.

- Анализ экономического эффекта в случае успешного и неуспешного внедрения алгоритма (модели).

- Создание и проработка ключевых показателей, по которым будет оцениваться эффективность созданной модели.

Перед тем как начинать работу с данными, необходимо взвесить все за и против, ведь методом анализа и машинного обучения можно решить далеко не все задачи бизнеса.

Не нужно начинать работу, если проблема, которую нужно решить, заведомо проигрышная.

Какими знаниями должен обладать специалист Data Science

- Английский язык. С ним вы будете сталкиваться ежедневно. От коммуникаций с зарубежными коллегами до изучения справочных материалов и документов к программному обеспечению.

- Высшая математика. Без нее вообще никак. Все математические модели построены на определенных законах, которые описаны в математике. Только лишь математический анализ недостаточен. Как минимум, вам понадобится линейная алгебра, статистика, теории вероятности.

- Специфика проекта или отрасли. К этой особенности науки о данных нельзя подготовиться, ведь у каждого конкретного проекта существуют свои особенности. Например, domain knowledge (предметная область) в оценке рисков для страховой отрасли будет совершенно не похожа на предметную область логистической ниши. Решение этой проблемы заключается в постоянном самообучении, а также в коммуникации с экспертами в каждой конкретной отрасли.

- Языки программирования. Выше мы частично упоминали, что хорошим набором будет «Питон», R и SQL. Такой набор будет достаточным для джунов. Для мидлов и сеньоров в этот набор желательно включить хотя бы Java и языки группы С, например C++. Кроме того, изначально необходимо иметь хорошее представление о библиотеках для выбранного языка, которые будут использоваться для работы с большими данными. В первую очередь, речь о Matplotlib, Numpy, SciPy и конечно Scikit.

Программирование, математика и алгоритмы, предметная область — на них держатся все знания специалиста по DS

Программирование, математика и алгоритмы, предметная область — на них держатся все знания специалиста по DS

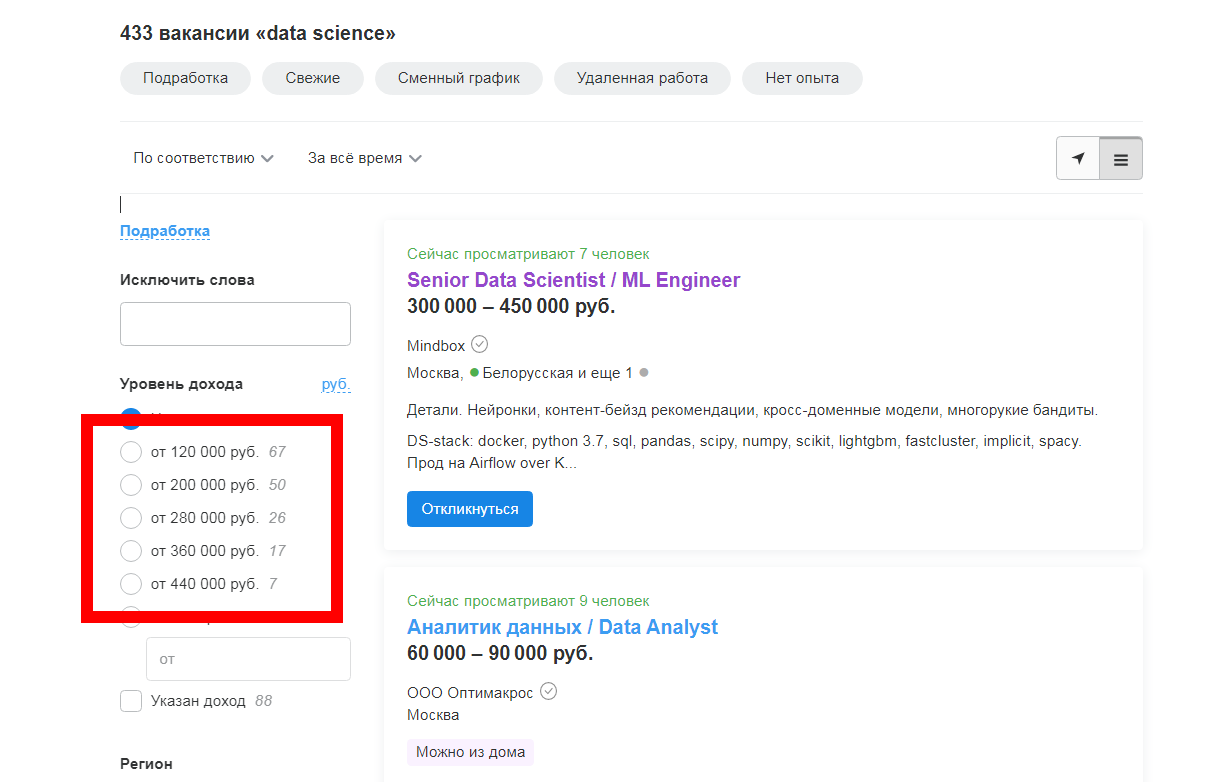

Зарплата программистов Data Science

По данным сайта zarplan.com, средняя зарплата для Data Scientist в России в октябре 2022 года составляет 270 231 рублей. Медианная зарплата — 233 000 рублей.

Мы проанализировали крупнейшие доски объявлений (rabota.ru, hh.ru, superjob.ru) и установили следующие показатели зарплаты для специалиста Data Science в октябре 2022 года:

- Джун: от 42.000 до 85.000 рублей.

- Миддл: от 90.000 до 240.000 рублей.

- Синьор: от 230.000 рублей.

Опытный специалист по Data Science с многолетним стажем работы в самых крупных компаниях России может получать более 400 000 рублей.

Уровень зарплат дата-сайентиста с учетом 433 вакансий

Уровень зарплат дата-сайентиста с учетом 433 вакансий

Уровень зарплат для специалиста по данным сильно варьируется не только от его стека знаний, но и от локации, где расположен работодатель. Традиционно компании из Москвы и центра России платят самые высокие гонорары своим специалистам. На уровень зарплаты также влияет и отрасль бизнеса.

Где искать заказы специалисту Data Science

Data Scientist редко работает как независимый специалист. Обычно он находится в составе компании и делает точные оценки и прогнозы по строгому техническому заданию бизнеса.

Тем не менее, внештатные специалисты в этом профиле также существуют, но компании больше заинтересованы в работниках, которые находятся в штате.

Биржи фриланса

Искать заказы по Data Science можно на этих десяти биржах:

- Workzilla.

- Upwork.

- Weblancer.

- AngelList.

- Indeed.

- Freelancehunt.

- Freelancer.

- Freelance.ru.

- Kaggle.

- Peopleperhour.

Доски объявлений

Не сбрасывайте со счетов и традиционные доски объявлений — hh.ru, rabota.ru, superjob.ru. Крупные российские компании часто ищут специалистов именно через эти площадки.

Сайты как profi.ru и YouDo

Используйте и сайты наподобие profi.ru (или YouDo). Зарегистрируйте профиль специалиста и укажите свою специализацию («Наука о данных»). На том же profi.ru, например, сейчас зарегистрировано более 4 000 программистов.

Telegram-каналы

Найти работу и заказы можно и в трех Telegram-каналах:

Ниже даем еще 18 каналов, в которых часто встречаются вакансии с самым разнообразным IT-профилем:

- Progjob

- Alenavladimirskaya

- Careerspace

- Solvery

- Myjobit

- Budujobs

- Jobforjunior

- ITlenta

- Jobskolkovo

- Remoteit

- Djinni_jobs_bot

- Forfrontend

- Seohr

- Theyseeku

- Distantsiya

- Antirabstvoru

- Remotejobss

- Yojob

Так выглядит типичный пост с вакансией на канале:

Пример вакансии на позицию «Специалист по данным» в одном из Telegram-каналов

Пример вакансии на позицию «Специалист по данным» в одном из Telegram-каналов

Если вы ищете вакансию в российской компании, попробуйте «Хабр Карьеру». Там очень часто публикуют предложения о найме для специалистов этого профиля.

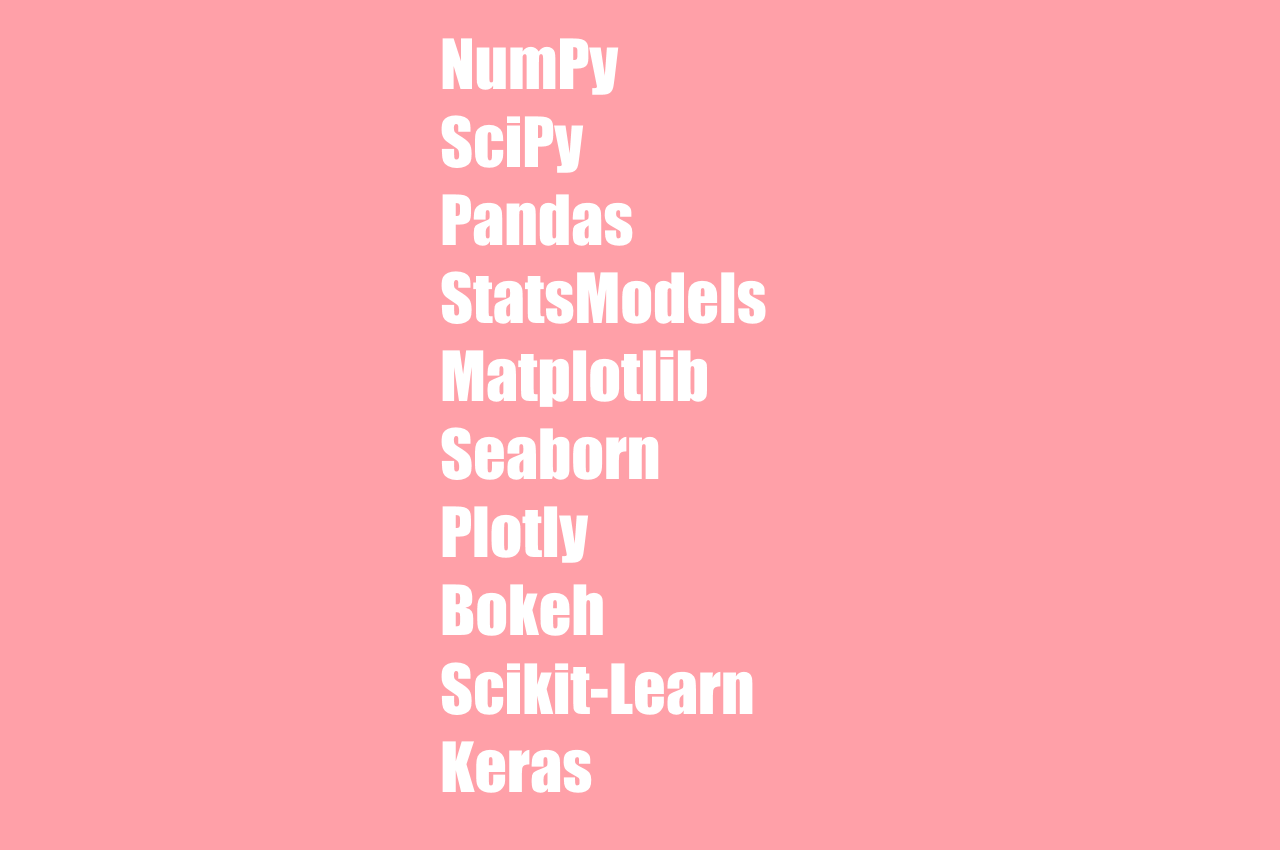

Инструменты Data Science

Главным орудием современного специалиста по данным можно назвать «Питон». Именно на этом языке осуществляется большинство этапов работы программиста по данным, включая анализ «сырых» данных, тестирование и эксперименты, написание кода, формирование моделей.

Что касается запросов к источникам, то чаще всего они оформляются на SQL. В случаях, когда специалист по данным является еще и инженером машинного обучения, ему понадобится превосходное знание языка C++.

Самые популярные Python-пакеты для специалистов по данным

Самые популярные Python-пакеты для специалистов по данным

Язык R также используется в качестве основного. Чем он лучше «Питона»? В первую очередь, качественной визуализацией. Зато тот же Python имеет максимальный элементарный синтаксис и огромное количество готовых библиотек для работы с Big Data. Возможно, R чуть сложнее для новичка, поэтому среди начинающих он распространен несколько меньше, чем Python.

Ниже мы рассмотрим относительно полный список тех инструментов, которыми пользуются специалисты по данным на регулярной основе в 2022 году.

Контейнеризаторы приложений

Их будет полезно знать тем, кто планирует развиваться в продуктивизации ML и смежных направлениях и создавать Machine-Learning-платформы — мультимодели с несколькими версиями. Нужно обязательно знать контейнеризаторы приложений Docker и популярный сейчас Kubernetes.

Sandbox

Без интерактивного блокнота, где можно мгновенно визуализировать выполнение кода, — никуда. В качестве этого инструмента разумнее всего задействовать Jupyter Notebook — универсальный блокнот для выполнения ряда задач:

- Отладка любых разделов кода.

- Удобные аналитические сводки.

- Проверка и тестирование анализа данных. Эксперименты.

- Сложный разведочный анализ.

- Визуализация данных в диаграммах, гистограммах и графиках.

- Работа с классами и методами.

Работа с pipeline и его настройка

Термин пайплайн, или конвейерная обработка, относится к методу разбиения последовательного процесса на подоперации, при этом каждая подоперация выполняется в выделенном сегменте, который работает одновременно со всеми другими сегментами. Здесь чаще всего используется Apache Airflow. В качестве альтернативы можно назвать фреймворк для «Питона» Luigi.

Machine Learning и создание ML-моделей

Рекомендуемые здесь библиотеки будут различаться в зависимости от тех потребностей, которые стоят перед разработчиком. Приведем библиотеки для самых распространенных сценариев машинного обучения:

- ИНС: Keras и TensorFlow.

- Одиночные модели: scikit-learn.

- Текст: NLTK.

- Классификация или несложная регрессия: LightGBM, XGBoost.

- Интерпретирование ML-модели: DiCE. В качестве полноценной замены можно рассматривать SHAP.

Среда разработки

Наилучший вариант PyCharm. Это интегрированная среда разработки с готовыми инструментами для анализирования кода, поддержкой Джанго, графическим отладчиком, и полноценными инструментами для организации и работы с юнит-тестами. Вот еще некоторые возможности, которые особенно пригодятся для дата-сайентиста:

- Комфортное написание Python-кода с реализацией любых модулей и классов.

- Отслеживание чистоты кода.

- Продуманное перепроектирование кода (рефакторинг).

- Умное форматирование текста.

- Настройка интерпретаторов.

- Полная поддержка распределенные системы управления версиями git.

Базы данных

Чем больше технологий хранения данных вы знаете, тем лучше. Минимальный набор: PostgreSQL, Oracle и конечно MySQL. В зависимости от особенностей проектов, может понадобиться знание Vertica и аналитической СУБД ClickHouse.

Точно не лишним будет умение работать с массово-параллельной СУБД Greenplum. Не стоит сбрасывать со счетов и апачевскую технологию Hadoop (особенно одноименную файловую систему HDFS), а также соответствующие фреймворки, утилиты и многочисленные библиотеки Hadoop. Все это понадобится при работе с данными. Чем больше будет ваш стек технологий, тем лучше и для самого специалиста, и для работодателя.

Облачные инструменты

Нужны навыки работы в облачных платформах Google (Google Drive, Google Cloud Platform, Google Colab) и Amazon (Redshift, AWS и конечно S3). Одними БД сегодня не обойтись и без знания облачных платформ дата-сайентисту делать нечего.

EDA и визуализация данных

Раз мы порекомендовали в качестве интерактивного блокнота JN, рассмотрим библиотеки именно для этой «песочницы». Три беспроигрышных варианта: Plotly, Matpotlib и питоновая библиотека Seaborn. Если вам этого мало, можно добавить в этот список scikit-learn.

Востребованность профессии дата-сайентиста

Профессия очень востребована. По разным оценкам, к 2025 году в мире будет циркулировать более 175 зеттабайт данных. Это колоссальная цифра, которая свидетельствует о постоянном количественном росте информации о людях.

Ваш маршрут на работу, ваш последний поисковый запрос в «Яндексе» о ближайшей кофейне, ваш пост во «ВКонтакте»о том, что вы ели и даже данные с вашего фитнес-браслета. Вся эта информация тщательно анализируется компаниями и в дальнейшем используется для того, чтобы сделать вашу жизнь лучше и удобнее.

Только представьте: абсолютно любой ваш шаг в интернете тщательно отслеживается сотнями различных компаний.

Несколько цифр, которые позволяют судить о востребованности этой профессии:

- Специальность с самым высоким спросом по результатам ВЭФ 2022.

- Суммарное число вакансий выросло более чем на 400 %. Об этом говорят hh.ru и независимые источники данных за последние три года.

- Более 400 вакансий на hh.ru.

- Более 350 вакансий на rabota.ru и superjob.ru.

Тренды Data Science в 2022-2023 году

В глобальном смысле, находя связи и закономерности, наука о данных позволяет создавать новые продукты, предоставляет обществу революционные идеи и делает нашу жизнь более комфортной. Существует мало проблем, которые не поддаются решению через анализ данных. Таким образом, наука о данных может использоваться абсолютно для всего: от принятия важных бизнес-решений до аналитики или оценки рисков.

Проверка гипотез и установление самых эффективных вариантов — еще одна область, где наука данных показывает себя наилучшим образом.

Напоследок предлагаем изучить семь трендов Data Science, которые станут особенно востребованными в 2023 году глобально. Обязательно учитывайте их уже сейчас.

1. Бум облачной миграции

68 % ИТ-директоров назвали «миграцию в общедоступное облако / расширение частного облака» главным драйвером расходов на IT в последнее время. Вскоре все больше бизнесов начнут готовиться к миграции приложений, помещая свои локальные приложения в контейнеры. Это будет связано с соображениями стоимости, нехваткой чипов и необходимостью масштабируемости. Компании перенесут свои онлайн-системы обработки транзакций, хранилища данных, веб-приложения, аналитику и ETL в облако.

Компании, у которых уже есть гибридные или мультиоблачные развертывания, сосредоточатся на переносе своей обработки данных и аналитики. Таким образом, они смогут переходить от одного поставщика облачных услуг к другому, не беспокоясь о периодах блокировки или использовании конкретных точечных решений.

2. Рост прогнозной аналитики

Предиктивная аналитика — это предсказание будущих тенденций и прогнозов с помощью статистических инструментов и методов, использующих прошлые и существующие данные. С помощью предиктивной аналитики организации могут принимать взвешенные бизнес-решения, которые помогут им развиваться. Ожидается, что к 2025 году мировой рынок прогнозной аналитики достигнет 21,5 миллиарда долларов США, а среднегодовой темп роста составит 24,5 %. Прогнозируемый невероятный рост связан с внедрением цифровой трансформации в ряде организаций. Сатья Наделла, генеральный директор Microsoft, заявила: «Мы увидели два года цифровой трансформации за два месяца».

3. Авто-ML

Автоматизированное машинное обучение или AutoML — одна из последних тенденций, которая способствует оптимизации рабочих процессов DS. Огромная часть работы специалиста по данным тратится на очистку и подготовку данных, и каждая из этих задач повторяется и требует много времени. AutoML обеспечивает автоматизацию этих задач и включает в себя построение моделей, создание алгоритмов и нейронных сетей не в полуавтоматических режимах.

4. TinyML

Это тип машинного обучения, который сжимает сети глубокого обучения, чтобы их можно было разместить на любом оборудовании. Универсальность, крошечный форм-фактор и экономичность — все это TinyML. Это одна из самых захватывающих тенденций в области науки о данных, с помощью которой можно создать ряд приложений. Встраивание искусственного интеллекта в небольшие устройства эффективно решает проблему недостатка мощности и пространства.

5. Лучшее регулирование данных

По данным G2, ежедневно создается 2 000 000 000 000 000 000 байт данных. Это 18 нулей. Только представьте, какая колоссальная цифра! Оптимизация больших данных не может быть второстепенной задачей. С проникновением ИИ в такие отрасли, как здравоохранение, конфиденциальные ЭМИ и данные пациентов не могут и не должны быть скомпрометированы. Да, утечки данных в российских и зарубежных компаниях — привычное дело. Но именно основные принципы конфиденциальности данных должны создать более безопасный подход к сбору и обработке ПДН. И машина будет выполнять эти задачи самостоятельно, нужно просто ее обучить.

6. ИИ как услуга (AIaaS)

Одна из самых больших проблем, связанных с AIaaS (искусственный интеллект как услуга), — соблюдение требований соответствия. Если ваш бизнес может выполнить свои нормативные требования и обязательства, то AIAaS — отличный способ быстро и масштабно создавать решения на основе ИИ.

7. Сложность обучающих данных

Несмотря на все разговоры о том, что данные — это новая нефть и их невероятную важность для компаний / бизнеса, большая их часть остается неиспользованной. Зарубежные практики такие данные называют «темными»: они, в основном собираются, обрабатываются и хранятся только в целях соблюдения формальных требований. Вдобавок ко всему, 80-90 % данных, которые сегодня генерируют бизнесы, не структурированы, анализировать их становится все сложнее.

К сожалению, это и одна из главных сложностей, которая препятствует применению контролируемого и неконтролируемого обучения. Есть определенные области, где большой репозиторий данных недоступен, и это может серьезно затруднить деятельность дата-сайентиста. Трансферное обучение, генеративно-состязательная сеть (GAN) и обучение с подкреплением решают проблему — уменьшают количество необходимых обучающих данных или генерируют достаточное количество данных, с помощью которых можно обучать модели.

1031 002

1031 002